29 марта 2023

Более тысячи экспертов вместе с Маском и Возняком призвали приостановить обучение передового ИИ

Группа экспертов в области искусственного интеллекта (ИИ) призвали в открытом письме шестимесячной паузе в разработке систем более мощных, чем недавно запущенный OpenAI GPT-4. Они объяснили своё обращение потенциальными риски для общества и человечества, которые несёт данная технология.

Письмо опубликовала некоммерческая организация Future of Life, где также предложено за эти полгода экспертам обсудить риски развития ИИ, сделать важные выводы, а также разработать и внедрить общие протоколы безопасности для таких проектов:

«Мощные системы искусственного интеллекта следует разрабатывать только тогда, когда мы уверены, что их эффекты будут положительными, а риски управляемыми».

В письме подробно описаны потенциальные риски для общества и цивилизации со стороны конкурентоспособных систем искусственного интеллекта в виде экономических и политических потрясений, а также содержится призыв к разработчикам сотрудничать с политиками над управлением и регулированием этой отрасли.

Подписанты подчёркивают, что мощные ИИ-системы должны разрабатываться только после того, как человечество будет уверено в позитивных последствиях такого развития, и в том, что связанные с ними риски будут управляемыми.

Помимо Илона Маска и отраслевых экспертов документ подписали Стив Возняк (соучредитель Apple), Эмад Мостак (гендир Stability AI) и другие. При этом исполнительный директор OpenAI письмо не подписал.

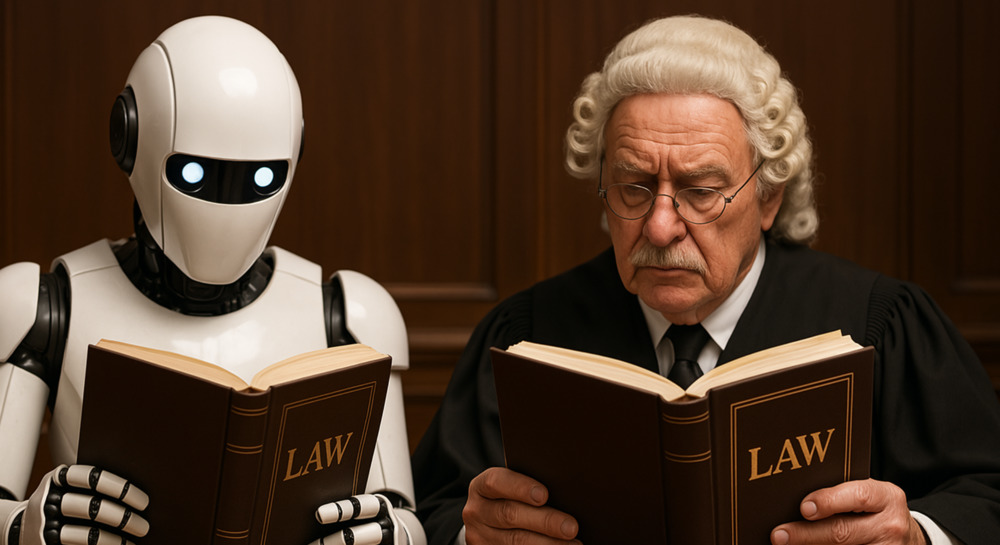

В свою очередь, Европол опубликовал на днях отчёт, в котором рассказал, что преступники уже используют ChatGPT для совершения преступлений. Полицейские утверждают, что злоумышленники используют его в преступных целях. Несмотря на то, что ИИ отказывается выполнять потенциально опасные запросы, некоторые пользователи смогли обойти систему фильтации, заставив его выдать инструкии о создании, например, самодельной бомбы или опасного наркотика. Кроме этого, можно попросить ChatGPT узнать, как совершать преступления, получив в ответ пошаговое руководство.

Организация также подчеркнула, что эту модель можно использовать для содействия киберпреступности, мошенничеству, фишингу, либо для производства пропаганды, дезинформации и поддержки терроризма.

Европол признаёт, что вся эта информация уже находится в открытом доступе в Интернете, но модель облегчает поиск и понимание того, как совершать конкретные преступления.

Письмо более чем тысячи экспертов прокомментировал и пресс-секретарь Президента РФ Дмитрий Песков. По его словам, власти России продолжат работу по развитию ИИ, но потребуется и его регулирование.

Представитель Кремля напомнил, что Владимир Путин неоднократно говорил о важности работы с ИИ, чтобы не допускать отставания России от общемирового уровня тех стран, которые «находятся впереди этой гонки». «Эта работа будет продолжаться... Что касается точки зрения тех, кто считает, что серьезные опасности кроются в развитии искусственного интеллекта, вы знаете, что любое лекарство при неправильном использовании превращается в яд»,— сказал Песков.

Похожие статьи

Наша рассылка

Главное за неделю в области права.

Контакты

18+

23 декабря 2022 года Минюст включил Роскомсвободу в реестр незарегистрированных общественных объединений, выполняющих функции иностранного агента. Мы не согласны с этим решением и обжалуем его в суде.