7 December 2020

ОГФ’2020: способна ли открытость данных улучшить отношения человека с ИИ?

По следам дискуссии о распознавании лиц, открытом коде и общественном контроле за алгоритмами.

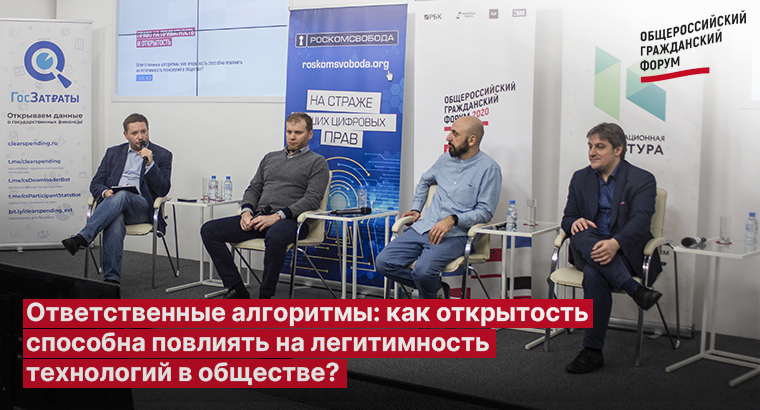

28 ноября «Роскомсвобода» совместно с «Информационной культурой» весь день вела на Общероссийском гражданском форуме площадку «Право на приватность и открытость». В рамках дискуссии «Ответственные алгоритмы: как открытость способна повлиять на легитимность технологий в обществе?» эксперты ответили на вопросы, где пролегает граница доверия к искусственному интеллекту (ИИ), ухудшает или улучшает безопасность открытый код и кто может его контролировать.

.

.

Соучредитель АНО «Инфокультура» Василий Буров, выступивший в качестве модератора, поставил перед первым спикером проблему — где пролегает граница, когда ИИ можно доверять решать за нас, а когда нет? Например, если распознавание лиц даёт точность в 73%, как относиться к оставшимся 27%?

Заведующий научно-учебной лабораторией LAMBDA факультета компьютерных наук НИУ ВШЭ Андрей Устюжанин, отвечая на это, сказал, что надо повышать общий уровень грамотности, для того чтобы разобраться в таких вещах, как процент распознаваемости и чем 73% отличаются от 74%. Он напомнил, что большая часть алгоритмов строится на том, что происходило раньше (на исторических данных), и по тем параметрам, которые определили люди, поэтому у искусственного интеллекта есть соответствующие ограничения. Кроме того, алгоритмы довольно редко знают пределы своей применимости, хотя и существуют уже такие, которые указывают степень собственной уверенности в выводах. Другой важный аспект, который следует иметь в виду на будущее, — возможность использования симуляторов физической, социальной, биологической и другой реальности для получения точной информации, которые принимают во внимание гораздо больше характеристик и которые всё чаще используют вкупе с машинным обучением.

.

Генеральный директор Zecurion Алексей Раевский порассуждал о том, должен ли код быть открытым с точки зрения безопасности. По его мнению, нельзя однозначно ответить, ухудшает или улучшает ли безопасность открытие исходных кодов. Надо понимать, что в открытых кодах сразу же найдут много дыр, которые придётся оперативно закрывать.

«Важно не то, как мы открываем алгоритмы и как их впоследствии сертифицируем, а важно то, каковы последствия использования этих алгоритмов. Не должно быть такого, что, например, штраф начисляется автоматически на основе решения алгоритма».

Помимо этого высокоуровневые логические хакеры могут, используя открытый код, обмануть систему в своих целях. Самый простой пример — приложение для автомобилистов, которое показывает, где стоят камеры, следящие за превышением скорости. С точки зрения водителей приложение удобно, потому что позволяет ездить, как хочется, и снижать скорость только там, где камеры. С точки же зрения общей безопасности, наверное, было бы лучше, если такого приложения не было и владельцам автомобилей приходилось бы постоянно думать о подстерегающих неизвестно где камерах и возможных штрафах.

.

Директор АНО «Информационная культура» Иван Бегтин говорил об общественном контроле за алгоритмами в аспекте безопасности раскрытия кода. По его словам, большая часть госсистем на данный момент не использует умные алгоритмы, но переход к принятию решений на основе ИИ постепенно происходит и у них. Примеры тому — Банк России, Росфин, Правительство. Там, где есть трансфер денег, это используют, резюмировал спикер. Хотя происходит это «крайне непублично».

Пока государство приближается к использованию ИИ, компании его уже внедряют ИИ. Однако у государства есть проблема — работа с уклоном в наказания.

«Если дошёл до суда, тебя либо оштрафуют, либо посадят, но оправдан ты не можешь быть. Главная функция адвоката — развалить дело до суда. Шансов, что тебя оправдают, мало. Что хорошего в алгоритме, у которого выборка будет изначально тебя посадить», — размышляет Бегтин.

Однако нерелевантную выборку можно поправить. Для этого, к примеру, в ЕС разрабатывается стандарт проверки алгоритмов, по которому ответственность за ИИ несут его разработчики. Если система что-то неправильно распознала — оштрафуют её авторов.

Раскрыть данные можно и нужно, убеждён Бегтин. Но в России пока некому проверять их и следить за искусственным интеллектом. Для этого нужно повышать квалификацию чиновников.

.

Завкафедрой философии образования философского факультета МГУ им. М.В. Ломоносова Елена Брызгалина, к слову, готова обучить чиновников на своём факультете, но при этом она ставит здесь вопрос целеполагания. Конец XX — начало XXI вв. ознаменовались тем, что получение знаний и их применение стали совпадать по времени, рассказала философ. Раньше можно было изучить тему, потом применить результаты исследования на практике. Теперь обучение систем происходит в процессе их создания. Регулирование, таким образом, должно распространяться не на только на приложения научных выводов, но и на постановку задачи, выбор методов и оценку результатов, а также последствий.

Как сделать данные открытые для более широкого круга людей? Человек не всегда опирается на одни только знания, но ещё и на ценности, заметила эксперт. Она перечислила эти ценности: инклюзивность, беспристрастность, надёжность, безопасность и ответственность. Отдельно — прозрачность вкупе с информированностью.

«Золотой стандарт — это представление о добровольном информированном согласии. Готов ли ты к тому, что сведения о тебе будут использоваться определенным образом?»

В плане контроля Брызгалина, можно сказать, соглашается с Бегтиным: в первую очередь здесь важна «добрая воля» разработчиков, их ответственность. Но она расходится с ним во мнении, что их чиновники их могут проверять. По её словам, это невозможно в принципе, поскольку только создатель знает, какое изменение он внёс в своё творение в тот или иной момент. Поэтому ответственность ложится на экспертов и общественный контроль и находится в области этики.

Глава юридической практики «Роскомсвободы», управляющий партнер Центра цифровых прав Саркис Дарбинян тоже посетовал, что юриспруденция не развивается экспертно, она давно уже не наука.

По его словам, депутаты действуют в духе «Давайте примем закон, а подзаконные акты о том, как их применять, напишет правительство».

Население не особенно доверяет государственным информационным системам, потому что те не раскрывают протекающие внутри процессы. Мы только догадываемся, как всё работает, но кто, когда загружает данные, как использует, с какой целью — не знаем. Это ярко иллюстрируют кейсы Сергея Межуева и Антона Леушина — первые известные нам случаи ошибки распознавания лица.

Поэтому право должно развиваться постепенно, с учётом специализированных знаний. Это, кстати, одна из причин, почему «Роскомсвобода» требует ввести мораторий на массовое распознавание лиц: в этой области нет правового и социологического исследования, хотя понятно, под прицелом камерам человек ведёт себя по-другому, нежели без них. Присоединиться к кампании против распознавания лиц можно здесь.

Другие материалы с ОГФ:

Similar articles

Our newsletter

The main news of the week in the field of law.

Contacts

18+

On December 23, 2022, the Ministry of Justice included Roskomsvoboda in the register of unregistered public associations performing the functions of a foreign agent. We disagree with this decision and are appealing it in court.