31 August 2021

Скрытая несправедливость: неправильное внедрение и регулирование технологий приводит к дискриминации

В Нидерландах Роджера Дерикса попросили вернуть правительству 68 тыс. евро. Кроме того, власти конфисковали его машину и на долгие годы сократили его зарплату на 40%. Дерикс был одним из 26 000 родителей, которых налоговое управление обвинило в мошенничестве с выплатами пособий, выявленное искусственным интеллектом. Как показало официальное расследование, система ИИ действовала «незаконно и дискриминационно», что в конечном итоге привело к отставке премьер-министра Нидерландов Марка Рютте в начале этого года.

[Investigation] The computer says no. How algorithms and artificial intelligence in the public sector is creating dangerous but invisible injustice, @alina_yanchur @kupact @rosenfog and @pilzsa write. https://t.co/wFQeT1zmR4

— EUobserver (@euobs) August 23, 2021

Но для Дерикса расследование началось слишком поздно. Финансовые трудности в конце концов развалили его брак. «Это большая цена», — сказал Дерикс.

ЕС предлагает этическое регулирование ИИ

Скандал в Нидерландах не уникален. Подобные злоупотребления происходят по всей Европе. Например, в Дании искусственный интеллект использовали для выявления детей в «уязвимых семьях», который особенно пристально следил за иностранцами.

В январе 61 правозащитная организация направила в ЕС открытое письмо с требованием обозначить границы для ИИ, угрожающего правам человека. В то же время представители отрасли заявили, что регулирование ИИ будет сдерживать развитие инноваций.

Новый президент Европейской комиссии Урсула фон дер Ляйен вывела регулирование искусственного интеллекта в приоритет, и в ЕС заявили, что ищут компромисс между устранением рисков и защитой инноваций.

К апрелю 2021 года Европейская объявила о долгожданном предложении по контролю искусственного интеллекта, которое, впрочем, не выходит за рамки этического регулирования.

Преимущество у бизнеса

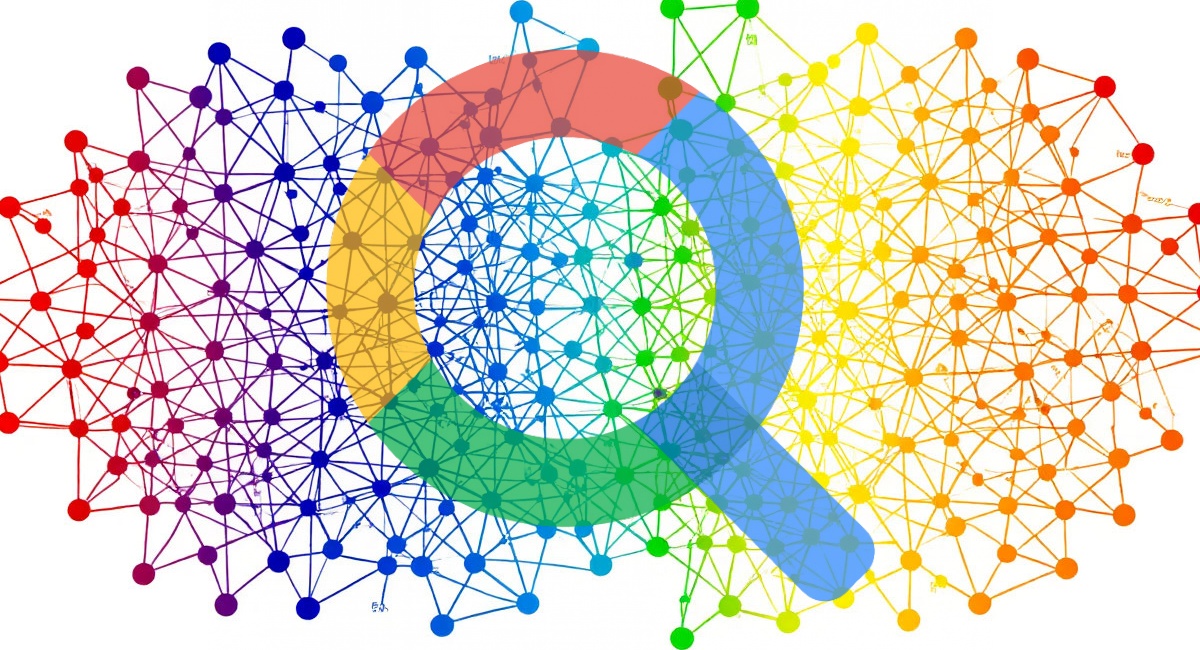

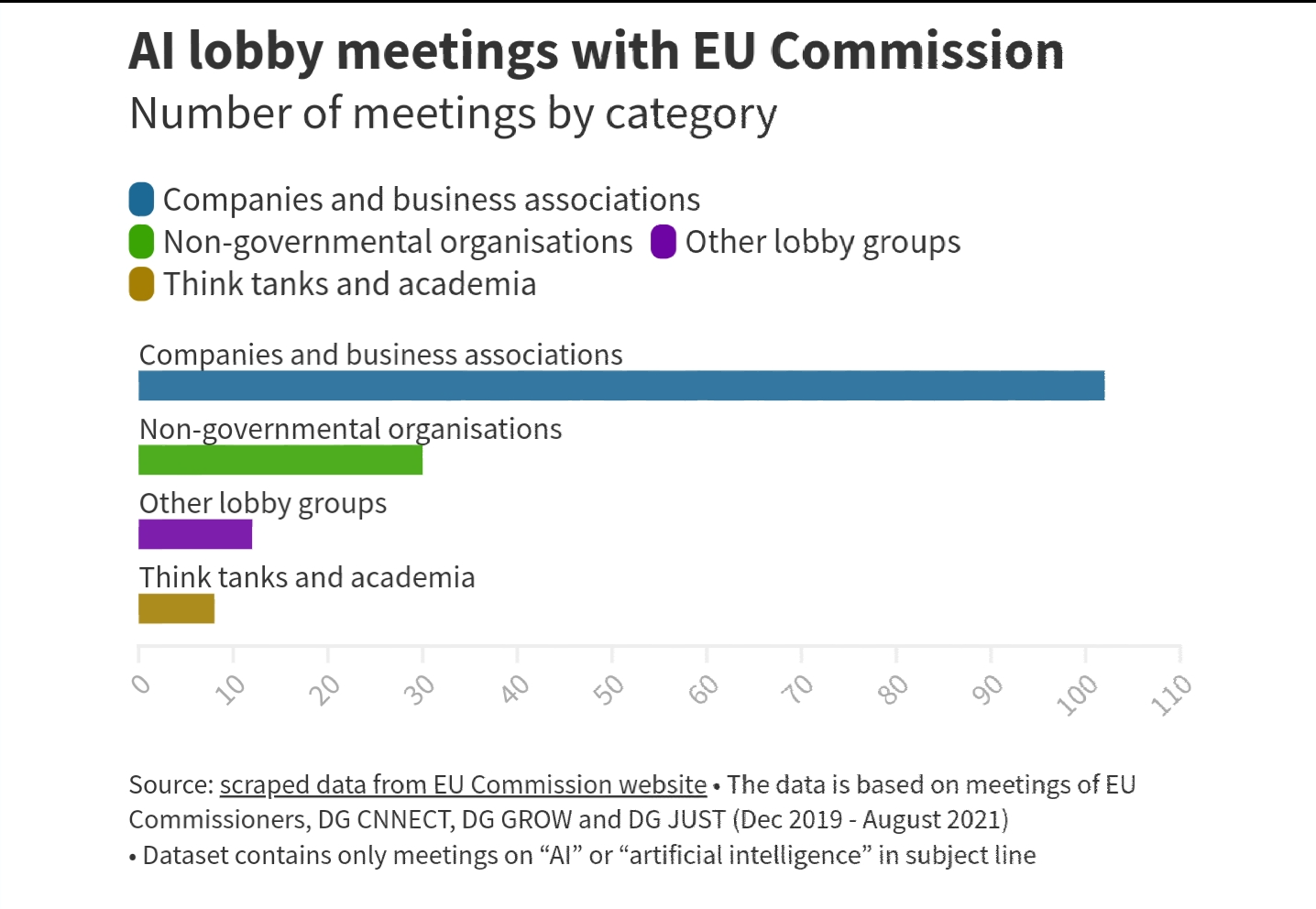

Европейская комиссия зарегистрировала 152 официальных заседания, лоббирующих внедрение ИИ, с декабря 2019 года по август 2021 года. На встречи с корпорациями пришлось более двух третей из их числа (100 заседаний). Менее одной трети — на встречи с представителями гражданского общества, учёных и профсоюзов. Большинство организаций встречались с представителями ЕС только один раз. Google, побывавший на девяти заседаниях, возглавил список.

«Такова демократия. И мы даем больше голоса тем, у кого больше всего денег», — заявила Маргарита Сильва из Corporate Observatory Europe, организации, отслеживающей корпоративное лобби.

«Отмывание этики»

Документы ЕС, изученные в EUobserver, свидетельствуют о том, каким образом технологические компании продвигали внедрение ИИ в государствах. Так, Google призывал «правительства содействовать продвижению ИИ в государственном секторе для создания процветающей экосистемы». А Microsoft говорила, что «государственный сектор мог бы извлечь огромную выгоду из использования решений на основе ИИ».

Кроме того, технологические фирмы уверяли в своей способности к саморегулированию. Facebook подчёркивал, что тратит 3,7 млрд долларов на то, чтобы оставаться «добросовестным». Google и Microsoft отмечали наличие у себя корпоративных принципов в отношении искусственного интеллекта. А лоббисткая организация DigitalEurope потребовала, чтобы в ЕС приняли «добровольную систему сертификации», в соответствии с которой компании сами будут оценивать, соответствуют ли их продукты ИИ требованиям ЕС, прежде чем выводить их на рынок.

Критики назвали такую практику «отмыванием этики»: компании утверждают о порядочности своего поведения, чтобы предотвратить контроль со стороны государств.

«Государственные органы часто не имеют возможности разрабатывать свои собственные системы искусственного интеллекта, что означает, что мы снова зависим от этих компаний», — сказала Урсула Пачл из Европейской организаци по защите прав потребителей.

ИИ и госсектор

То, что произошло с Дериксом в истории с пособием на ребенка, чётко проиллюстрировало риски, которые ЕС намеревался предотвратить с помощью регулирования, признал один из чиновников Евросоюза. Однако он добавил, что нельзя прекращать использовать искусственный интеллект, просто нужно проработать внедрение технологий как следует. По его словам, это в интересах всех, включая IT-индустрию.

Правда, опасения по поводу того, обеспечивает ли предлагаемая система сертификации и самооценки компаний достаточную защиту для граждан ЕС, остаются, пишет EUobserver.

В недавно опубликованном ответе членов экспертной группы ЕС по ИИ сделан чёткий вывод, критикующий один только этический подход, без надлежащего обеспечения законом: «Предложение не обеспечивает адекватной защиты основных прав, как и достаточных мер по поддержанию верховенства закона и демократии и, таким образом, не обеспечивает юридически надёжного использования ИИ».

Скрытая несправедливость

Вред от алгоритмов, как известно, трудно увидеть. Дерикс потратил годы на суды, в которых доказывал свою невиновность. Другие потеряли опеку над своими детьми или даже покончили с собой.

«Большинство дел пройдут незамеченными. Люди даже не будут знать, что решения об их жизни принимаются автоматизированной системой», — рассказывает Сара Чандер, руководитель отдела политики в European Digital Rights.

«Издержки по-прежнему лежат на пострадавших людях», — добавляет Даниэль Лейфер из Access Now, организации, защищающей цифровые права.

В Нидерландах пострадавшим обещали компенсацию в размере 30 тыс. евро. Однако «родителям все еще нужно бороться за каждый пенни, — говорит Дерикс. — Но я этого так не оставлю».

Similar articles

Our newsletter

The main news of the week in the field of law.

Contacts

18+

On December 23, 2022, the Ministry of Justice included Roskomsvoboda in the register of unregistered public associations performing the functions of a foreign agent. We disagree with this decision and are appealing it in court.