19 February 2024

Исследователи и учёные предлагают радикальные меры контроля ИИ

Группа исследователей, куда входят учёные Университета Кембриджа, компания OpenAI и и исследовательское сообщество GovAI, предупреждают о появлении потенциально опасных вычислений в области искусственного интеллекта (ИИ), которые могут привести к непредвиденным катастрофам, если не воспринимать их должным образом.

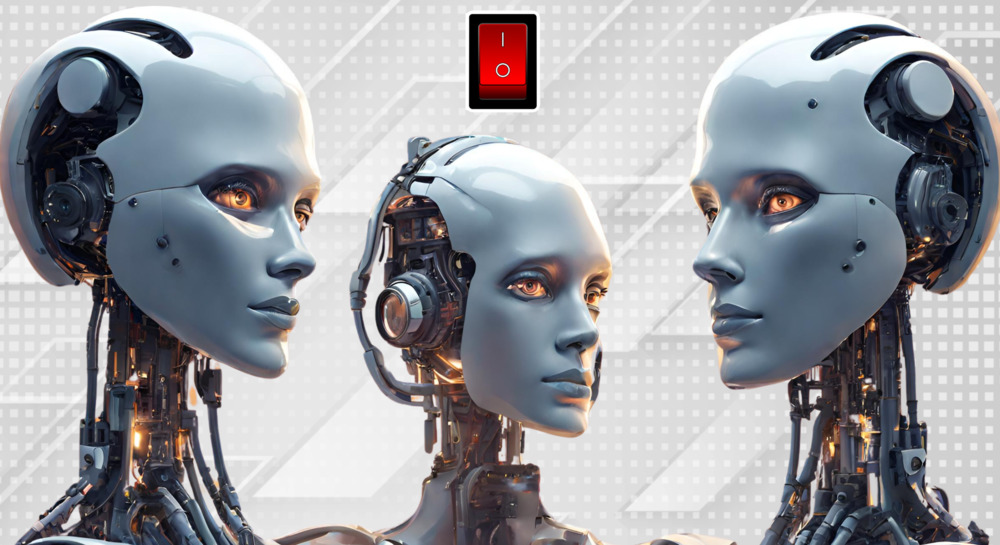

Они предлагают интегрировать в аппаратное обеспечение, на котором работает ИИ, удаленные выключатели и блокировки. По их мнению, регулирование аппаратного обеспечения может стать эффективным инструментом контроля. Учитывая, что обучение самых мощных моделей ИИ требует значительной физической инфраструктуры и времени, авторы утверждают, что существование и производительность таких ресурсов сложно скрыть. Кроме того, производство передовых микросхем для обучения моделей сосредоточено в руках нескольких компаний, таких как Nvidia, AMD и Intel, что дает возможность ограничивать продажу товаров определенным лицам или странам.

«За последнее десятилетие искусственный интеллект добился поразительного прогресса, во многом благодаря резкому увеличению вычислительной мощности, применяемой к алгоритмам обучения, — сказал Гайдн Белфилд, соавтор отчета из Кембриджского LCFI. — Правительства справедливо обеспокоены потенциальными последствиями ИИ и ищут способы регулирования этой технологии, но данные и алгоритмы нематериальны и их трудно контролировать. Суперкомпьютеры искусственного интеллекта состоят из десятков тысяч объединенных в сеть чипов искусственного интеллекта, размещенных в гигантских центрах обработки данных, зачастую размером с несколько футбольных полей, потребляющих десятки мегаватт энергии».

Авторы предлагают несколько мер по регулированию аппаратного обеспечения для ИИ, включая улучшение видимости и ограничение продажи ускорителей ИИ. Например, в США существует исполнительный акт, направленный на идентификацию компаний, разрабатывающих крупные модели ИИ двойного назначения, а также поставщиков инфраструктуры, способных их обучать. Кроме того, Министерство торговли США предложило регулирование, которое потребует от американских облачных провайдеров внедрить более строгие политики Know Your Customer (KYC) для предотвращения обхода ограничений на экспорт.

Одним из радикальных предложений исследования является внедрение в процессоры выключателей, которые могут предотвратить использование микросхем в злонамеренных целях. Такие выключатели могут позволить регуляторам отслеживать законность использования ИИ-чипов и дистанционно отключать их в случае нарушения правил. Кроме того, предлагается создать глобальный реестр продаж ИИ-чипов, который будет отслеживать их на протяжении всего жизненного цикла, даже после того, как процессоры покинули страну происхождения.

Авторы также рассматривают возможность использования механизмов, аналогичных тем, что применяются для контроля над ядерным оружием, требуя многократного подтверждения для запуска потенциально рискованных задач обучения ИИ в масштабах. Однако они предостерегают, что такие инструменты могут помешать разработке полезных ИИ, поскольку последствия использования ИИ не всегда столь однозначны, как в случае с ядерным оружием.

Несмотря на потенциальные риски, исследование также выделяет возможность перераспределения ресурсов ИИ в интересах общества, предлагая сделать вычислительные мощности ИИ более доступными для групп, маловероятно использующих их во зло. Ученые подчеркивают, что регулирование аппаратного обеспечения ИИ может стать дополнением к другим мерам регулирования в этой области, подчеркивая его более легкую контролируемость по сравнению с другими аспектами разработки ИИ.

Similar articles

Our newsletter

The main news of the week in the field of law.

Contacts

18+

On December 23, 2022, the Ministry of Justice included Roskomsvoboda in the register of unregistered public associations performing the functions of a foreign agent. We disagree with this decision and are appealing it in court.